2/23

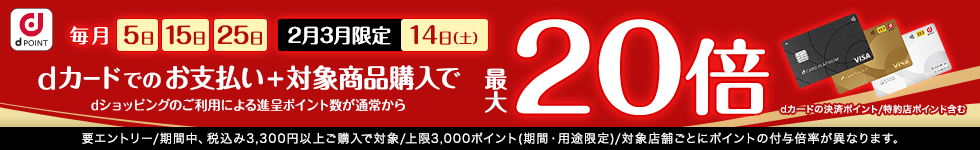

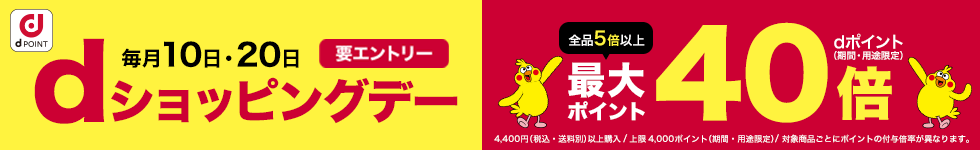

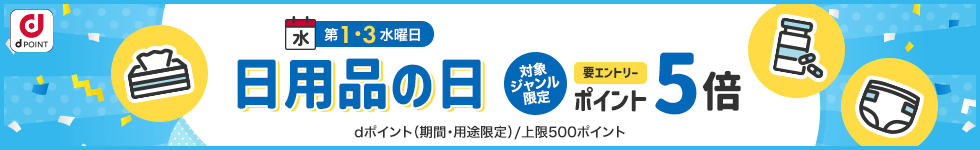

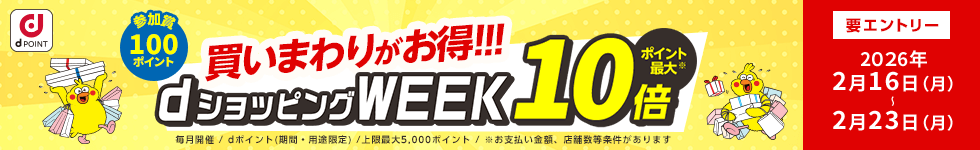

時点_ポイント最大11倍

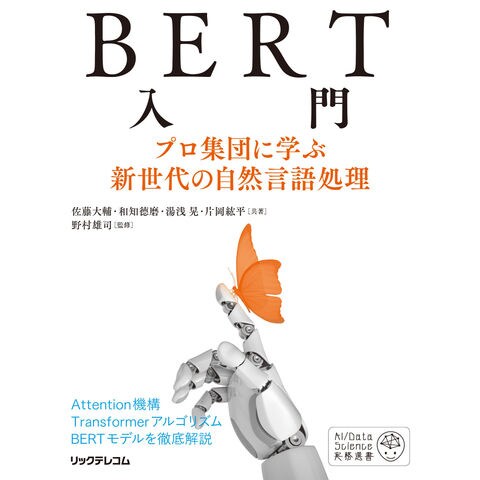

BERT入門 プロ集団に学ぶ新世代の自然言語処理 /佐藤大輔 和知□磨 湯浅晃

販売価格

2,420

円 (税込)

- 出荷目安:

- 1~2営業日で出荷

たまるdポイント(通常) 22

+キャンペーンポイント(期間・用途限定) 最大10倍

※たまるdポイントはポイント支払を除く商品代金(税抜)の1%です。

※表示倍率は各キャンペーンの適用条件を全て満たした場合の最大倍率です。

各キャンペーンの適用状況によっては、ポイントの進呈数・付与倍率が最大倍率より少なくなる場合がございます。

dカードでお支払ならポイント3倍

各キャンペーンの適用状況によっては、ポイントの進呈数・付与倍率が最大倍率より少なくなる場合がございます。

- 商品情報

- レビュー

≪商品情報≫

著者名:佐藤大輔、和知□磨、湯浅晃

出版社名:リックテレコム

発行年月:2022年08月

判型:B5

ISBN:9784865943405

≪内容情報≫

◆Attention機構、Transformerアルゴリズム、BERTモデルを徹底解説◆

BERTの登場により、自然言語処理(NLP)におけるAIのビジネス適用が劇的に進展し、続々と新しい技術が生まれています。主流となったBERTをきちんと理解すれば、新世代のNLPにキャッチアップできます。

本書では、技術開発はもちろん実務経験も豊富なNLPの専門家集団が、Attention機構、Transformerアルゴリズム、BERTモデルを徹底解説。プロフェッショナルチームが仕組みを詳しく、現場で使えるコードをやさしく手引きします。

著者名:佐藤大輔、和知□磨、湯浅晃

出版社名:リックテレコム

発行年月:2022年08月

判型:B5

ISBN:9784865943405

≪内容情報≫

◆Attention機構、Transformerアルゴリズム、BERTモデルを徹底解説◆

BERTの登場により、自然言語処理(NLP)におけるAIのビジネス適用が劇的に進展し、続々と新しい技術が生まれています。主流となったBERTをきちんと理解すれば、新世代のNLPにキャッチアップできます。

本書では、技術開発はもちろん実務経験も豊富なNLPの専門家集団が、Attention機構、Transformerアルゴリズム、BERTモデルを徹底解説。プロフェッショナルチームが仕組みを詳しく、現場で使えるコードをやさしく手引きします。